читайте также

О чем только не говорят в холлах исследовательских лабораторий Microsoft Research в Редмонде, штат Вашингтон. Сегодня здесь услышишь новости о многих вещах, вроде бы не имеющих отношения к информатике: о том, как вращаются галактики, о новой вакцине против СПИДа, о стратегиях экономного использования драгоценных запасов пресной воды на планете.

Что общего в этих разговорах и почему всем этим интересуются в корпорации Microsoft? Ответ прост: информация, колоссальные объемы информации. Они настолько огромны, что, когда мы запускаем программы, анализирующие базы данных, в здании, где работают 10 тысяч микропроцессоров, на несколько градусов повышается температура. Сейчас наши компьютерщики вместе с ведущими учеными — астрономами, биологами, химиками, гидрологами, океанологами, физиками, зоологами и многими другими — работают над множеством информационноемких проектов. Для примера назовем разработку принципиально новых лекарств, развитие альтернативной энергетики, создание информационной базы для здравоохранения, с помощью которой можно будет сократить его расходы. И, разумеется, коммерческие информационные проекты. Мы уверены, что еще немного, и, благодаря новому поколению мощных программных средств, позволяющих обрабатывать беспрецедентные объемы данных, доступные множеству разных специалистов, в этих областях знания будут сделаны революционные открытия.

Уже не один десяток лет программисты пытаются заставить компьютер думать, как думают специалисты в той или иной области. Разработаны сложнейшие языковые и логические алгоритмы.

Но, несмотря на все усилия, машины до сих пор не выдают творческих идей и решений, которые приходят на ум лучшим ученым, врачам, инженерам и маркетологам. Талантливые профессионалы не только глубоко понимают информацию, но и видят «между строк», обнаруживая неочевидные связи внутри науки или на стыке наук. В этом и есть суть прозрений. Но сейчас информации столько, что в ней тонут даже светила наук. Цифровые данные текут рекой из всевозможных датчиков, приборов и моделей, их гораздо больше, чем мы можем классифицировать, анализировать и сохранять. В полном соответствии с законом Мура десятилетиями количество микросхем на интегральной схеме удваивалось каждые два года, и до недавнего времени миниатюризация сопровождалась ростом производительности микропроцессоров. Сейчас, чтобы увеличить производительность, надо программировать сложные процессоры на многоядерных чипах, применяя параллельные вычисления. Многоядерная революция грянула как раз тогда, когда начался экспоненциальный рост объема информации. Эту проблему не решить с помощью «заплаток» и апгрейда — надо полностью пересмотреть подход к наукам, требующим обработки большого количества информации. Потому-то несколько лет назад наш покойный коллега Джим Грей, обладатель самой престижной в области информации премии Тьюринга, ввел термин и дал определение «четвертой парадигмы» научного исследования. Грей предвидел, что появится новый мощный инструментарий для анализа, визуализации, поиска и управления научными данными. Эти средства, похоже, дадут единственный надежный шанс решить некоторые глобальные задачи.

Первые две парадигмы научного исследования и открытия — эксперимент и теория — известны давно. Научный опыт как метод восходит к древним грекам и китайцам, которые стремились объяснять наблюдаемое не сверхъестественными, а естественными причинами. Теоретическое естествознание родилось в XVII столетии, и его родоначальником считают Исаака Ньютона.

А когда во второй половине XX века появились мощные компьютеры, нобелевский лауреат Кен Уилсон сформулировал третью парадигму научного исследования — вычисление и моделирование. Компьютерная симуляция, основанная на множестве уравнений, позволили ученым углубиться в области, которые ранее были недоступны для эксперимента и теории, вроде климата или образования галактик.

«Четвертая парадигма» тоже связана с мощными компьютерами. Только теперь не программы пишут на основе известных закономерностей, а, наоборот, закономерности выявляют с помощью программ. Ученые нацеливают алгоритмы на поиск взаимосвязей и значимых корреляций в громадных базах данных. По сути, программы позволяют открывать новые правила. Большой объем данных для нас — не проблема, а часть решения. «Четвертая парадигма» не пытается обойтись вовсе без человека и не отрицает три другие методологии — но она требует новой квалификации ученых. Даже опытнейший специалист не смог бы выйти на те идеи, что сейчас забрезжили на горизонте, если бы он не владел сложными компьютерными средствами управления информацией.

«Машинное обучение» спасает жизни

Для начала проясним, каким типом мышления нужно обладать для такого рода исследований. В 1980-х годах мой коллега Эрик Хорвич учился на врача и проходил практику в госпитале для ветеранов. Там он обратил внимание на тревожную закономерность: в праздничные дни палаты заполнялись больными с острой сердечной недостаточностью. Обязательно находились пациенты, которые, несмотря на слабое сердце, весь год как-то «тянули», но после праздничного застолья попадали в госпиталь. Из-за лишней соли организм накапливал много жидкости, это приводило к отеку легких и одышке и нередко заканчивалось больничной койкой.

Эти послепраздничные приступы обходились дорого во всех смыслах. Порой они уносили жизни: одни умирали мгновенно, другие угасали за несколько дней или недель, по мере того, как выходили из строя физиологические системы. Кому-то везло — их состояние удавалось быстро стабилизировать. Но и этих больных надо было неделю или больше держать в больнице, что обычно обходилось системе страхования ветеранов от $10 до $15 тысяч на пациента (а сегодня эти счета были бы еще выше).

Через двадцать с лишним лет Эрик и его коллеги из Microsoft Research разработали компьютерную методику, позволившую исключительно точно предсказывать, будет ли человек в течение месяца снова госпитализирован с острой сердечной недостаточностью. Суть метода не в том, что компьютеру поручили задавать все вопросы вместо врача-диагноста. Это и не обезличенная статистика повторной госпитализации. Предполагалось так называемое машинное обучение: программа перепахивает всю информацию, содержащуюся в гигантской базе данных (в нашем случае — значения сотен характеристик примерно по 300 тысячам пациентов) в поиске значимых корреляций. Машина сама распознает, какие комбинации факторов создают наибольшие риски, а стало быть, и выявляет пациентов, которые с высокой вероятностью поступят в больницу повторно. Программа вычисляет предрасположенность к рецидиву: она проанализировала тысячи историй болезней с уже известным исходом и благодаря этому, когда в больницу попадает новый пациент и данные по нему собраны, ей легко определить его шанс вскоре оказаться здесь снова.

Этим проектом мы в каком-то смысле обязаны специалисту, выявляющему неочевидные связи. Эрик — дипломированный врач, но у него есть и PhD по информатике, и он понял, что методы машинного обучения, вроде тех, с помощью которых он и его коллеги анализировали движение транспорта в Сиэтле, подойдут и для решения этой важной для здравоохранения проблемы. В 2003 году они разработали способ прогнозирования транспортных пробок, учитывающий данные о движении транспорта по автомагистралям, метеосводки, сообщения о ДТП, о мероприятиях с большим скоплением людей и еще многие факторы. Огромные массивы данных накапливались несколько лет. Та же команда создала программу, сравнивающую данные о пациентах, которые были и не были повторно госпитализированы. Ее задача — выявить взаимосвязи между малоприметными фактами в истории болезни пациента, его медицинскими показателями и даже социальными и экономическими характеристиками (например, живет ли пациент один). Данные собирали из разных источников — скажем, в медицинской карте информации о жизненных обстоятельствах пациента нет, но часто ее можно отыскать в отчете социального работника. Едва ли лечащий врач был бы в состоянии в одиночку переработать объем показателей, необходимый для составления подобного прогноза.

Представим себе, какую экономическую выгоду сулит применение прогностических средств. Зная вероятность повторной госпитализации пациента, врачам или больницам легче принимать адекватные превентивные меры. Вот что говорит Эрик: «Для хронических больных, например с сердечной недостаточностью, можно разработать индивидуальные программы выписки, объяснить человеку все, что он должен знать, и вести мониторинг, чтобы поддерживать его в стабильном, безопасном для жизни состоянии. Эта программа также предполагает, что медсестры будут посещать пациентов или звонить им по телефону. Ее можно дополнить специальными тестами, отмечающими опасные отклонения в водном балансе пациента, о которых будет сообщаться врачу. Если мы потратим хотя бы $500 или $1000 на программы выписки для пациентов с наибольшим риском рецидива, нам удастся свести к минимуму повторные госпитализации, тем самым сэкономить деньги и сделать лечение более эффективным».

Неудивительно, что страховые компании и больницы выстраиваются в очередь, чтобы узнать о таких вещах. И легко себе представить, какие еще организации выиграют от открытий, связанных с обработкой большого количества информации.

На Уолл-стрит мощные программы «прочесывания» информации отслеживают долгосрочные тенденции и паттерны по различным видам инвестиций. Хедж-фонды и финансовые компании ежедневно ставят на кон миллионы долларов, учитывая эти извлеченные из данных взаимосвязи.

В бизнесе у программ, улавливающих паттерны, большое будущее. Выявляя с их помощью закономерности в ценах, покупательских привычках, в характеристиках географических регионов, в доходах семей и многих других массивах данных, компании смогут по-новому анализировать покупателей и рынки. А получив доступ к гигантским объемам информации об эффективности рекламы, лояльности покупателей и их удовлетворенности, о текучести кадров и организации цепочек поставок, — прогнозировать поведение каждого потребителя или сотрудника и вероятность всякого рода проблем. Мы знаем, что компании все чаще выявляют сбои в проплатах и в дебиторской задолженности, «прочесывая» данные. Программы также могут прогнозировать, какой доход должен принести определенный набор услуг. Мы работали с одним провайдером медицинских услуг в Нью-Мехико: за первые шесть месяцев пользования подобными инструментами он выявил недоплаты на $10 млн.

Есть шуточное правило: половина вложенных в рекламу денег окупается, только мы не знаем, какая именно. Новые аналитические методики его отменят. Филиппинская компания из сферы электронных развлечений, применяя технологию Microsoft извлечения значимой информации из данных, разрабатывает новые продукты для конкретных категорий пользователей — на основе расширенного анализа таких факторов, как прошлые покупки, возраст, пол, финансовые условия и место жительства. Как только компания внедрила эту технологию, процент приобретений мелодий для мобильных телефонов и другой продукции удвоился.

Многие спрашивают, для чего Microsoft Research работает над глобальными медицинскими и экологическими проектами, когда есть столько коммерческих задач? В конце концов, разве экологией и гуманитарными проблемами занимается сама корпорация Microsoft, а не Фонд Билла и Мелинды Гейтс? Все так, и тем не менее в Microsoft Research десятки программистов ломают голову над явно некоммерческими задачами, потому что по ним собраны базы данных невообразимого масштаба и потому что это — бесценный испытательный полигон. Расширять возможности мышления и инструментария лучше всего, занимаясь серьезными проблемами, чрезвычайно важными для всего человечества. К тому же это открывает новые перспективы для сотрудничества и экспериментирования. Если специалисты, представляющие разные области знания, будут обмениваться данными, у нас появится больше шансов для стремительного движения вперед. Как любил говорить Джим Грей, самое ценное в данных астрономии — то, что они не обладают коммерческой стоимостью.

Освещаем дно океана

Один из таких масштабных проектов — океанологический. Сейчас на дне Тихого океана к западу от штата Вашингтон и Британской Колумбии ведется строительство. Океаны, покрывающие 70% поверхности Земли, — это самая крупная экосистема планеты. Они формируют погоду; в них зарождаются цунами и ураганы, мощные, опасные и большей частью непредсказуемые явления; в толще воды больше углерода, чем в атмосфере, растительности и почве; наконец, океан — важнейший источник продуктов питания. И несмотря на это, о морском дне нам известно меньше, чем о поверхности Марса или Венеры. Вода не пропускает электромагнитное излучение, с помощью которого мы изучаем небесные тела, поэтому для океанологических исследований приходилось применять подводные лодки, корабли и спутники. Но скоро ситуация изменится. Океанологи — участники проекта Обсерватории океана (OOI) с бюджетом $600 млн, выделенных Национальным научным фондом США, — разместят на участке тихоокеанского дна сеть элементов, назначение которых мой коллега Роджер Барга определяет как «USB-порт океана». OOI протянет 2500 километров кабеля ко дну океана и между датчиками, подключит их к источнику питания и к интернету, чтобы фиксировать разного рода явления и их точное время. А ученые с помощью разных устройств — от обычных термометров до роботов с дистанционным управлением и современных генных секвенаторов — будут эти явления изучать.

Проект задуман как международный. Он даст ученым беспрецедентную возможность оценивать и анализировать природные процессы вроде образования ила или изменения плотности микроорганизмов. Но полученные данные необходимо правильно классифицировать и хранить, иначе все сведется к мертвому грузу цифр. Вот почему Роджер и его группа работает непосредственно с потоком данных, попутно решая, как их распределить между компьютерами, чтобы нигде не перегружать отдельные вычислительные мощности и чтобы ученые, студенты и просто энтузиасты имели к этим данным доступ. Группа разрабатывает стандарты данных, которые позволят аналитическим программам сопоставлять результаты разных экспериментов — для более масштабного анализа. Возможность сочетать информацию из разных источников называется интероперабельностью (совместимостью) данных. А исследователям необходимо соединять и сравнивать данные, полученные с помощью прогностических моделей в лабораториях, с информацией из других источников, в том числе поступающей из сети OOI со дна океана.

«Для нашего времени характерно частое появление и быстрое сближение множества новых развивающихся технологий», — говорит Роджер. Исследование будет направлено на поиск корреляций между разными океаническими процессами, оно углубит наше представление о взаимосвязи суши, океана и атмосферы и, наверное, повысит нашу способность прогнозировать изменения. Ученые смогут количественно оценивать доселе недоступные подводные явления: вулканическую активность, крупные закономерности миграции морских организмов, землетрясения и мощные штормы. Видеосъемка, новые способы визуализации данных позволят студентам, преподавателям и всем желающим наблюдать за развитием этих явлений, а иногда и проводить собственные эксперименты. «Интернет станет самым мощным океанографическим инструментом», — предсказывает Роджер.

Проект OOI будит творческую мысль океанологов: в разных странах разрабатывают новые приборы для подводной лаборатории. В их числе автоматический подводный секвенатор ДНК — устройство размером со стиральную машину. Он будет отфильтровывать обитающие на дне моря живые организмы, считывать и классифицировать их ДНК и отправлять результаты на сушу. Это само по себе впечатляет. Но представьте себе, что информацию о ДНК объединят с данными о загрязнении окружающей среды, кислотности, температуре воды в океане, наличии кочующих биологических видов, способных повлиять на пищевую цепочку (все эти базы данных собраны другими исследователями), и вот оно — наступление новой эры в океанологии.

Какая в этом коммерческая составляющая? Вот лишь один пример. Химик, работающий в нефтяной компании над проблемой нейтрализации пролившихся в воду углеводородов, получает доступ к базе данных ДНК морских организмов. Он может сразу же генетически определить микроорганизмы, обитающие в воде вокруг какого-нибудь нефтяного пятна, и сказать, как на них скажутся реагенты, которые предполагается использовать для борьбы с загрязнением. У ученых, которые борются сейчас с последствиями разлива нефти в Мексиканском заливе, нет комплексных базовых параметров, чтобы оценивать «здоровье» океана. Им приходится ориентироваться на косвенные данные вроде состояния рыбы. Инструменты совместимости могут подсказать и более прозаические, но не менее полезные идеи. Скажем, начальник маркетинга в розничной компании получает ежедневные аналитические отчеты. Их составляет программа — перепахивая данные, которые поступают в режиме реального времени с кассовых терминалов магазинов разных стран. Программа распознает аномалии в продажах и прибыли и выявляет зависимости, которые большинство ритейлеров никогда бы не заметили.

Нет инфекциям и засухам

«Четвертая парадигма» ускоряет открытия еще и потому, что поставлять данные и предлагать идеи, приближающие ученых к прорыву, может каждый из нас. Например, во время транспортного проекта в Сиэтле водители-добровольцы с GPS навигаторами в машинах поставляли важную информацию о местных магистралях, просто перемещаясь по ним. Потом тот же метод применили и к более масштабной задаче: прогнозированию скопления машин в мегаполисах и на подъездах к ним. Сейчас в 72 крупных городах Северной Америки автомобилисты могут пользоваться картами поисковика Bing, созданными в рамках этого проекта (во врезке «Толпы в небесах» рассказывается о подобном проекте из области астрономии). Скоро все ученые-любители, какой бы наукой они ни увлекались, смогут собирать и анализировать информацию, пользуясь мобильным телефоном или ноутбуком.

Вот пример. Моя научная группа ведет проект в Индии. Его цель — задействовать сеть агентов, живущих в отдаленных районах, людей без медицинского образования в диагностике некоторых заболеваний. Люди из глубинки по мобильным телефонам звонят в медицинской центр, отвечают на ряд вопросов и тут же получают готовые обоснованные диагнозы. Когда-нибудь эту систему можно будет использовать для того, чтобы отслеживать и изучать распространение заболеваний, особенно инфекционных. Благодаря тому, что множество людей проводят быструю первичную диагностику, результаты которой вводятся в базу данных, государственные чиновники и работники здравоохранения сразу видят, где произошла вспышка того или иного заболевания, как оно распространяется, какие проявляются симптомы. При подключении «машинного обучения» в режиме реального времени каждую новую вспышку сравнивают со всеми известными эпидемиями этого инфекционного заболевания и других — и выявляют закономерности, помогающие предупредить дальнейшее распространение.

При таком масштабе проекта требования к технологии огромны: нужны вычислительные мощности, параллельное программирование, архивирование данных, их проверка, публикация. Если, допустим, архивирование не встроено в систему, участники проекта выполняют его, когда сочтут нужным, а это может привести к ненадежным и отнюдь не универсальным решениям. Когда речь идет о таких насущных проблемах, как изменение климата, нехватка воды или прогнозирование ураганов и цунами, ученые и политики не могут позволить себе дожидаться, пока все прояснится, и только потом действовать.

Например, в трудном положении оказалась Калифорния. Предполагается, что к 2040 году население штата вырастет с нынешних 38 млн до 50 с лишним. Вот что говорит Джефф Дозьер, профессор Школы экологии и менеджмента Калифорнийского университета: «Экономика Калифорнии зависит от запасов воды. Мы всегда стремились удовлетворять спрос. Не исключено, что больше мы этого делать не сможем. Мы привыкли к комфорту — надежное водоснабжение кажется нам в порядке вещей, — но природе до этого дела нет. Сейчас, чтобы спрогнозировать, сколько воды мы потратим в том или ином году, нужны новые, гораздо более совершенные технологии».

Определить, сколько воды прибудет в результате таяния снега, не так просто, как кажется, объясняет Дозьер. Спутники собирают массу данных о снежном покрове, но и этого недостаточно, поскольку просчитывается площадь, покрытая снегом, но не его объем или масса. Чтобы точно учесть поверхностный сток, надо знать «водный эквивалент», то есть количество воды, образуемой в результате таяния. Водный эквивалент можно вывести исходя из веса снега, но на больших участках местности со сложным рельефом вес этот измерить трудно. Вопрос: как объединить данные о водных запасах и снежном покрове с информацией об экономике и управлении — чтобы лучше оценить водные ресурсы, спрогнозировать их объем и лучше регулировать расход воды? В одной Калифорнии функционируют минимум 400 различных «водных» агентств. Microsoft работает с учеными из Калифорнийского университета в Беркли и из Национальной лаборатории Лоуренса. Они собирают и проверяют старые гидрологические данные, чтобы, объединив их с новейшими показателями, получаемыми от сетей датчиков, создать более точные прогностические модели.

Еще один ученый Microsoft — Дэвид Хекерман, доктор медицины и обладатель PhD по информатике — решает другую сверхактуальную общечеловеческую проблему: как обработка большого объема информации помогает в борьбе с вирусом иммунодефицита. «ВИЧ в организме одного пациента за несколько лет успевает мутировать столько раз, сколько вирус гриппа — за всю свою историю», — объясняет он. Поэтому так трудно разработать вакцину, которая в состоянии убить вирус ВИЧ. Более того, из-за различий иммунных систем в каждом организме вирус мутирует по-своему. Ученые надеются, что ВИЧ удастся остановить, если появится вакцина, стимулирующая иммунную систему самого человека на борьбу с вирусом. Хекерман и его коллега из Гарварда Брюс Уокер рассчитывают в скором времени приступить к тестированию первой вакцины, созданной на основе этих исследований.

Переключить скорость — и поменять стандарты

Для решения прикладной задачи вроде разработки вакцины, как и для фундаментальной — скажем, расшифровка генома человека, требуется огромный объем информации. Зато количество научных дисциплин, задействованных в этих проектах, не столь велико. А вот при изучении природных феноменов — океанических процессов или изменения климата — приходится иметь дело не только с массой информации о каждом отдельном факторе, но и с множеством научных дисциплин и источников данных. Для комплексных расчетов динамики потепления надо учитывать тепловое излучение, отраженное от полярных ледников, таяние шельфовых льдов, вызванное небольшими повышениями температуры воды, состояние мангровых лесов в тропиках, глобальные тенденции изменения величины популяций насекомых, рисунок древесных колец, уровень остаточного углекислого газа в ледяном керне и многое другое. И поскольку используются все больше массивов данных, собранных совершенно разными науками, задача разработки стандартов — для хранения и совместимости разнородной информации — выходит на передний край. По нашему мнению, в будущем существенно изменится характер научных публикаций. Как нам видится, нынешний «конечный продукт» — статья, в которой обсуждаются эксперимент и выводы и приводятся ссылки на массивы данных, — превратится в «обложку» для этих самых данных. Другие исследователи, получившие к ним доступ, смогут с их помощью решать собственные научные проблемы или, соединив их со своими массивами, выдвинуть идею, о которых первый исследователь и не задумывался. По удачному выражению Джима Грея, грядет «мир, где вся научная литература есть в интернете, все собранные данные совместимы и тоже есть в интернете. А для этого нужно много новых инструментов и методов». Достижение этой цели будет означать перемены к лучшему для общества и для планеты. Кроме того, «четвертая парадигма» создаст огромные коммерческие возможности. Скажем, геномный анализ ВИЧ, выполненный Дэвидом Хекерманом, — это лишь небольшая часть громадной программы индивидуальной медицины. Фармацевты считают, что, если выяснить, какие препараты подходят человеку с конкретными генетическими данными, разработка лекарственных средств пойдет по новому руслу. Health Solutions Group, подразделение Microsoft, сводит медицинскую документацию и данные диагностической визуализации. Это — первый шаг к созданию интеллектуальных средств для фармакологии. Все научные дисциплины, включая информатику, должны объединить свои усилия, чтобы «четвертая парадигма» дала решение важных проблем человечества. Ответы спрятаны в горах цифр, и в наших силах откопать этот клад.

Четыре научные парадигмы

ТЕОРИЯ

Еще в Древнеи? Греции и Древнем Китае люди стремились объяснить наблюдаемые явления не сверхъестественными, а естественными причинами.

ЭКСПЕРИМЕНТ

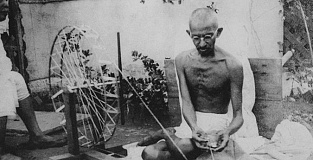

В XVII столетии ученые, такие как Исаак Ньютон, пытались предсказывать явления природы и экспериментально проверять свои гипотезы.

ВЫЧИСЛЕНИЕ И МОДЕЛИРОВАНИЕ

Во второи? половине XX века были созданы высокопроизводительные компьютеры. С их помощью ученые начали исследовать сложные процессы — например, моделировать климат или образование галактики — методом решения уравнении?, описывающих множество параметров в хорошем приближении.

ИЗВЛЕЧЕНИЕ ИНФОРМАЦИИ ИЗ ДАННЫХ

Работая на более мощных компьютерах, ученые начали «учить» программы «прочесывать» гигантские базы данных в поисках взаимосвязеи?. По сути, сопоставляя данные, они с помощью компьютеров открывают новые правила.

Толпы в небесах

Не только Microsoft: как помогают двигать науку другие компании

Информатика помогает совершать прорывы в области здравоохранения, изменения климата и т.п. В начале 2009 года в Центр по контролю и предупреждению болезней (CDC) начали приходить сообщения о сильной вспышке гриппа в Мексике. Чтобы лучше разобраться в ситуации, врачи обратились к Google.org — благотворительному подразделению Google, где с 2008 года работает сервис Flu Trends по мониторингу и прогнозированию распространения гриппа в нескольких странах. Результаты показали, что это новое заболевание (пандемия свиного гриппа, как оказалось) хотя и охватило немалую часть населения Мексики, вовсе не было таким опасным для жизни, как боялись в CDC. «Когда речь идет о пандемии, нужно много надежных источников информации, — говорит Жаклин Фуллер, руководитель Google.org. — Flu Trends может помочь органам здравоохранения составить реальную картину». Сейчас Google уже распространила проект Flu Trends на 28 стран.

Прежде Google.org в основном выделяла гранты сторонним организациям. Но теперь, говорит Фуллер, в компании поняли, что своим опытом, умением агрегировать и обрабатывать данные «Google.org сама может сделать многое». В числе проектов организации — Earth Engine: с помощью спутниковых изображений и методов анализа отслеживается уничтожение лесов — главная причина изменения климата. Google.org применяет технологию и для помощи в кризисных ситуациях. После землетрясений на Гаити и в Чили Google вместе с Госдепартаментом США создала базу данных Person Finder для внесения и поиска информации о пропавших. Google.org занимается благотворительностью, но есть и те, кто нашли «четвертой парадигме» прибыльные применения. В 2008 году IBM запустила проект Smarter Planet Initiative — гендиректор Сэм Палмизано назвал его главным источником будущего роста IBM. Опыт аналитики и интеграции применяют к решению таких проблем, как управление транспортом в Стокгольме, контроль водных ресурсов Мальты, здравоохранение в Китае. (IBM, в частности, разработала программу, которая позволит проверить действенность традиционной китайской медицины.) «Это точка, где сходятся сложные социальные проблемы, опыт компаний вроде IBM и заманчивые коммерческие составляющие», — говорит Майкл Валоччи, вице-президент IBM по глобальным бизнес-услугам.