читайте также

После того как в ноябре 2022 г. компания OpenAI представила общественности свой чатбот ChatGPT, созданный на основе технологии GenAI, Google выпустила собственного чатбота под названием Bard (сейчас он называется Gemini). Во время первой открытой демонстрации Bard допустил серьезную фактическую ошибку в ответе на вопрос об открытиях, сделанных космическим телескопом Джеймса Уэбба (James Webb Space Telescope). Этот неверный ответ чатбота привел к падению курса акций Alphabet, материнской компании Google, на 9% — на тот момент их рыночная стоимость составляла $100 млрд.

Случаи, показывающие опасность слепого использования чатботов, происходят в разных областях. В 2023 г. два юриста были оштрафованы Федеральным окружным судом Нью-Йорка за то, что представили юридическое обоснование, содержащее вымышленные дела и юридические цитаты, сгенерированные чатботом ChatGPT. А в журналистике некоторые известные издания оказались в неловком положении после использования контента, сгенерированного чатботами. Например, в Sports Illustrated было опубликовано несколько статей, написанных авторами с вымышленными именами и фотографиями, сгенерированными искусственным интеллектом.

В обоих случаях и отдельные специалисты, и компании слепо копировали контент чатботов, и это только верхушка айсберга. Поспешный выпуск на рынок чатботов, использующих большую языковую модель (LLM), вызвал множество проблем, связанных с тем, что эти инструменты врут и дают ложную информацию. В результате руководители и компании все чаще сталкиваются с новыми рисками, основанными на ожиданиях и отраслевых стандартах о точности информации.

В этой статье мы рассмотрим природу таких рисков и предложим рекомендации по управлению ими, основываясь на результатах наших исследований.

Новые инструменты, новые риски

Среди искренних обещаний и волнений по поводу возможного применения чатботов есть то, что мы называем «эпистемологическим риском бот-бреда». По нашему определению, бот-бред — это выдуманный, неточный и ложный контент чатбота, который люди бездумно используют для решения задач.

Неэффективное управление рисками, возникшими от бреда, сгенерированного ботами, может иметь серьезные последствия как для отдельных специалистов и руководителей, так и для их организаций. Некоторые из этих рисков включают в себя репутационный ущерб, неверные решения, возникающие правовые обязательства, экономические потери и даже безопасность людей.

Сфера здравоохранения — отличный тому пример. Внедрение чатботов в медицинских учреждениях, таких как аптеки, имеет очевидные преимущества. Чатботы могли бы работать круглосуточно, чтобы оперативно отвечать на вопросы о рецептах и аптечных услугах. Однако исследователи, выступавшие на ежегодном собрании Американского общества фармацевтов в 2023 г., обнаружили, что в настоящее время около 75% ответов ChatGPT на вопросы, связанные с лекарствами, были неточными или неполными. Хуже того, когда исследователи просили инструмент предоставить источники, на чьем основании был дан ответ, он выдавал фальшивые цитаты, создавая тем самым ложную информацию. Если бы врач слепо следовал подсказкам ChatGPT (или перекладывал на него свои обязанности), он бы подверг опасности жизни своих пациентов. Недавний систематический обзор исследований, посвященных использованию ChatGPT в здравоохранении, показал, что этот инструмент был задуман стать полезным как для прикладных (то еcть клинических рабочих процессов), так и для пользовательских задач, но были обнаружены его недостатки в предоставлении потенциально ложной и опасной информации и в том безапелляционном тоне, которым эта информация сообщалась.

Эта гипотетическая опасность стала реальностью в стартапе Babylon Health, который разработал приложение с искусственным интеллектом под названием GP at Hand («врач под рукой»). Приложение обещало сделать процесс сортировки пациентов более эффективным и гораздо более дешевым. Больные вводили свои симптомы, а приложение давало им рекомендации о том, к какому медицинскому специалисту необходимо обратиться (и надо ли вообще). После запуска приложения несколько врачей в Великобритании обнаружили, что оно дает неверные советы. Например, в программе Newsnight на BBC был показан сюжет, в котором врач рассказывал, как приложение «диагностировало» два заболевания, не требующих экстренного лечения, в то время как на самом деле эти симптомы могли быть признаками сердечного приступа. Правильным советом было бы немедленно вызвать скорую помощь. Когда стало ясно, что обещания приложения слишком преувеличены и даже опасны, оно потеряло свою многообещающую привлекательность, а компания, создавшая его, в итоге закрылась.

Бот-бред: управление рисками

Несмотря на такие случаи, как GP at Hand, использование чатботов в компаниях и профессиональной среде вряд ли сойдет на нет. Напротив, мы считаем, что технология генеративного ИИ открывает новые возможности при четком понимании и минимизации связанных с ним эпистемилогических рисков.

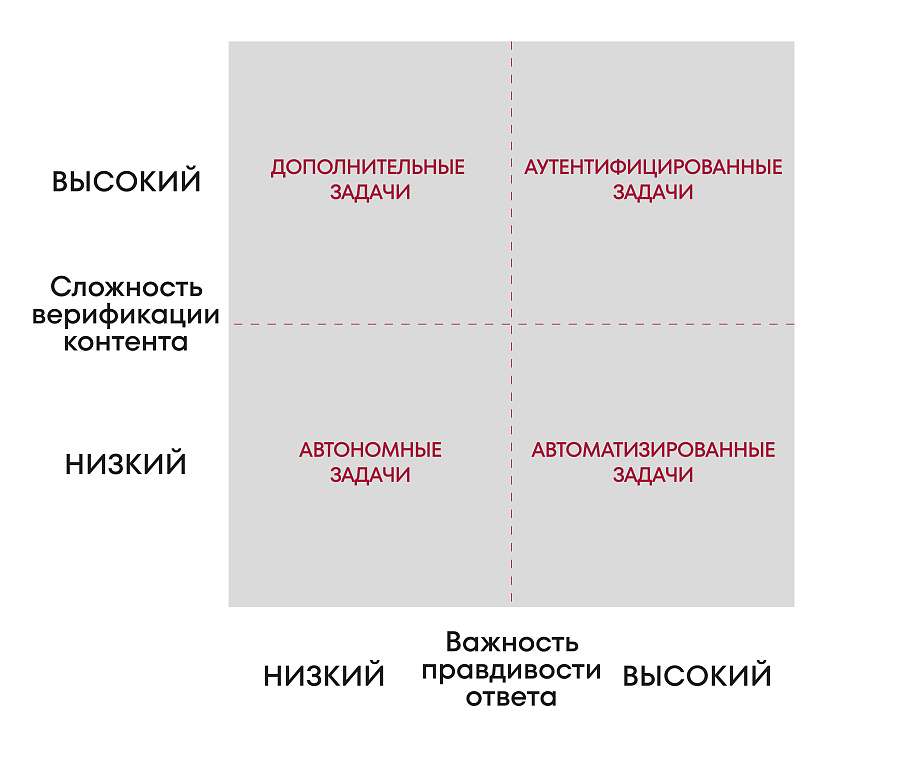

Чтобы решить эту проблему, в нашем исследовании мы используем два параметра для описания эпистемилогических рисков, которые несут в себе чатботы. Насколько важна правдивость ответа чатбота для выполнения задачи? И насколько сложно проверить правдивость ответа чатбота? Некоторые рабочие задачи требуют высокого уровня достоверности — важно, чтобы ответы чатбота были точными и правдивыми. Например, задачи, связанные с вопросами обеспечения безопасности, здравоохранением и образованием. С другой стороны, есть задачи, где не так важно, чтобы ответ был абсолютно точным и правдивым, — например выработка идей для нового продукта или услуги, создание сюжета для развлекательного контента или словотворчство при наименовании брендов и логотипов продуктов.

Вторым важным аспектом эпистемилогического риска является то, насколько сложно проверить создаваемый контент. Некоторые задачи позволяют относительно просто проверить ответ, полученный от генеративных инструментов ИИ. Например, трейдеру несложно проверить котировку акций публично котируемой компании в определенный момент времени. Однако есть задачи, где гораздо сложнее проверить конкретное утверждение. Сложно будет проверить информацию продавцу, пытающемуся проверить слухи о готовящемся новом продукте конкурента, или рекламщику, желающему определить жизнеспособность новой идеи для рекламной кампании.

Сложив эти два аспекта, мы получаем четыре различных типа задач, в решении которых могут помочь генеративные чатботы, каждый тип связан с различными рисками, требующими разного управления.

Понимание рисков разных задач, которые используют чатботы

Во-первых, определитесь с ответами на два вопроса. Насколько важна правдивость ответа чатбота для выполнения задачи? Насколько сложно проверить правдивость ответа чатбота? Как только вы поймете, какой тип задачи выполняется, то сможете лучше управлять рисками, связанными с задачей.

Аутентифицированные задачи

При выполнении аутентифицированных задач достоверность утверждений чатбота имеет решающее значение, но зачастую ее трудно проверить. В качестве примера можно привести сложные задачи по составлению бюджета, проверку процедур безопасности (например, процесс клинической диагностики для рентгенологов, изучающих снимки пациентов) или принятие правовых решений. В таких ситуациях наибольший риск, с которым сталкиваются пользователи чатботов, — это неправильная калибровка, когда нет точной связи между результатами работы чатбота и важными фактами или информацией. Именно это и произошло, когда два нью-йоркских юриста, о которых мы упоминали в начале статьи, представили в суд дело, содержащее выдуманные ссылки на правовые нормы, сгенерированные ChatGPT.

Однако этот риск можно минимизировать путем тщательной проверки и калибровки большой языковой модели (LLM) чатбота и выдаваемых им результатов. Помимо учета параметров самой рабочей задачи, необходимо обучать тестировать модель бота на достоверность, а также выявлять и устранять ограничения модели. Такую калибровку может производить грамотный специалист, который будет проверять результаты работы чатбота на соответствие общепринятым фактам. Это говорит о ценности чатботов, созданных для конкретной задачи, а не чатботов общего назначения (как, например, ChatGPT). Перспективные направления развития чатботов, ориентированных на конкретные задачи, включают использование новых технологий больших языковых моделей (LLM), таких как генерация ответа, дополненная результатами поиска (retrieval augmented generation — RAG), а также разработку пользователями методик создания подсказок. При эффективном использовании подсказок в актуальной последовательности пользователь и чатбот могут совместно придумывать идеи и исправлять потенциальные ошибки.

Дополненные задачи

Второй контекст включает в себя дополненные задачи, в которых правдивость или точность вывода не особенно важна, а проверить правдивость или уместность выводов ИИ сложно. Это происходит в задачах, требующих исследовательского или творческого мышления, таких как мозговой штурм или придумывание идей. В таких задачах основной риск заключается в незнании того, когда важную информацию или идеи упустили из виду или, возможно, когда по ошибке допустили наличие неподходящей информации. Например, на конкурсах краудсорсинга идей эксперты по инновациям оценили идеи, генерируемые чатботом, как более осуществимые, более эффективные, но менее новые, чем идеи, исходящие от человека. Это подчеркивает важность наличия соответствующих специалистов-людей, которые могли бы дополнить на первый взгляд творческие ответы машин.

Третий способ применения генеративного ИИ — это автоматизированные задачи, где точность ответа жизненно важна, а информацию относительно легко проверить. Примерами таких задач могут служить оценка заявок на получение кредита или проверка функциональности программного кода. В этих случаях основной риск заключается в рутинизации. Это происходит, когда люди чрезмерно полагаются на результаты работы ИИ и перестают время от времени проверять корректность ответов. Так произошло, когда пассажир авиакомпании Air Canada, у которого недавно умерла бабушка, зашел на сайт компании, чтобы спросить, каковы правила в отношении путешествий по причине тяжелых семейных обстоятельств. Чатбот дал неверный ответ, из-за которого пассажир не смог получить возмещение затрат на поездку. Новость об этой административной ошибке автоматизированной системы разлетелась по всему миру, когда клиент добился возврата денег, подав на авиакомпанию в суд.

Риск, возникающий при автоматизации, можно регулировать, если установить требование, чтобы человек периодически управлял автоматизированными процессами и проверял оценки и решения бота. Это гарантирует, что люди смогут заметить ошибки — и пользователи не «заснут за рулем».

Автономные задачи

Последний способ использования генеративного ИИ в работе — это автономный контекст, в котором точность или истинность ответа чатбота не так важна, а проверить результат относительно легко. Примером таких задач может служить обработка рутинных клиентских или административных запросов. В этих контекстах основной риск, который создает ИИ, — это автономное систематизирование систем до состояния «черного ящика», когда становится трудно или невозможно понять, как работает та или иная технология ИИ. Именно это произошло, когда французская почтовая компания DPD запустила чатбот для ответов на вопросы клиентов. Как минимум в одном случае чатбот ругался матом и писал хокку (японские лирические трехстишия), в которых критиковал компанию. Учитывая, насколько сложными могут быть чатботы, бывает трудно определить, откуда берутся такие ошибки и как их предотвратить.

В подобных контекстах риски можно регулировать с помощью обучения и ограничения диапазона ответов и словарного запаса LLM-модели чатбота. Чтобы обеспечить надежность и снизить бредовость ответов, сфера использования чатбота должна быть более узкой, а защитные ограничения, то есть правила, рекомендации или ограничения для использования чатбота, — более строгими.

. . .

Чатботы и другие инструменты, основанные на генеративном искусственном интеллекте, обладают огромным потенциалом для оптимизации многих рабочих процессов. Однако, как и любая другая важная новая технология, они сопряжены с рисками. Как показывают приведенные нами примеры, если пустить на самотек эпистемилогические риски использования бот-бреда, то это может дорого обойтись для отдельных людей, компаний и профессий. Однако при должном управлении эти риски можно ограничить, а преимущества чатботов реализовать в полной мере.